¿Quién escribe mejor, la máquina o yo?

En el artículo anterior (podéis consultarlo aquí) planteábamos una serie de textos a varias personas para ver si podían determinar, si el autor era una persona o ChatGPT. En este artículo mostraremos los resultados del ensayo, pero antes vamos a aclarar por qué hemos seleccionado esos textos.

Dedicación requerida

A las personas nos supone más esfuerzo escribir sobre algo que desconocemos. Queríamos comprobar si la diferencia de calidad de los textos (si es que existe) compensa el esfuerzo dedicado a su redacción.

Por ello hemos seleccionado dos temas sobre los que el autor tiene un cierto nivel de conocimientos.

- En cuanto a la primera pregunta (Ramones), el autor es un fanático del que es, sin duda, el mejor grupo de rock de la historia (y punto).

- Respecto a la segunda, (Vegetación potencial de la provincia de Segovia), aunque pueda sonar a chiste, es una pregunta real de un examen de Botánica en tercer curso de Ingeniería de Montes (el autor indica que clavó esa pregunta).

El autor consultó fuentes de información, pero no tuvo que dedicar un tiempo excesivo. Si desconociera todo sobre estos temas, la búsqueda requeriría tal esfuerzo que directamente hubiera optado por la versión automática.

Tipología de las preguntas

Se ha intentado realizar el estudio comparando dos tipos de pregunta bien diferenciados:

- Con el texto de los Ramones, se buscaba una pregunta más enciclopédica, es decir, la propia enumeración ordenada de una serie de datos, sin más.

- Por el contrario, la segunda pregunta es algo más compleja, ya que es necesario exponer:

- unos conocimientos de geografía (clima, orografía y geología de Segovia) y botánica (especies de plantas, donde viven, etc.)

- una capacidad de abstracción; cuál sería la vegetación potencial de la provincia de Segovia teniendo en cuenta lo anterior

- una capacidad de comparación de escenarios (vegetación real versus vegetación potencial)

¿Cuáles son las respuestas válidas?

¿Y qué ha respondido la gente?

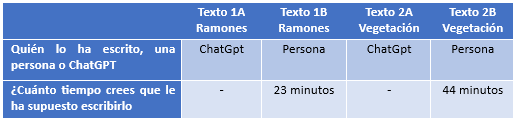

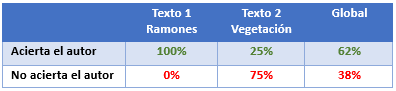

En primer lugar, la enviamos a 20 personas, con un total de 8 respuestas, con los siguientes resultados

En cuanto al autor

Aquí tenemos la primera de las situaciones extrañas. Sólo dos personas acertaron el autor del segundo texto, claramente más complejo por su tipología. Es evidente que el contenido de la versión humana es mucho más detallado, con datos complejos, salvo que se conozca en profundidad la materia. Así pues, llegamos a una primera conclusión: las personas no son capaces de discernir el autor de los textos.

Curiosamente algunas personas, han detectado detalles que podrían haber servido claramente para saber quién es el autor. Por ejemplo, en el primer texto (Ramones), versión automática, se indica que uno de los miembros era baterista. Este término está aceptado por la RAE, pero una persona jamás habría utilizado esa palabra; emplearía batería.

El segundo texto es más difícil de discernir, pero hay algunos detalles, el más significativo es la reiteración de términos en alguna frase. Este hecho ha sido detectado por una persona especialmente inteligente que además es mi sobrina (le viene de familia, claro). En una frase, cuando se detalla la red hidrográfica, se incluye dos el término surca. Este tipo de errores no se suelen producir cuando el autor es ChatGpt.

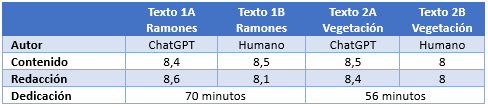

En cuanto a la calidad y contenido de los textos

Las valoraciones de texto son muy similares, tanto en contenido como en redacción. Llama mucho la atención el caso 2, ya que se valora más el contenido del texto automático.

Como explicamos, este caso es una pregunta real de examen. El autor conoce el tema perfectamente; de hecho, los contenidos en este texto son mucho más amplios y detallados… A modo de anécdota, se puede asegurar que la respuesta de ChatGpt sería un suspenso (que cada cual saque sus conclusiones en este sentido).

No nos centraremos mucho en analizar el tiempo que ha supuesto redactar los textos. La dedicación estimada por los encuestados es superior a la real, pero recordemos que el autor tiene conocimientos suficientes para redactar ambos textos en un tiempo relativamente corto. De no ser así, dicha dedicación hubiera sido muy superior.

Conclusiones

Generalizando mucho, podemos afirmar que:

- En general, las personas no suelen ser capaces de distinguir si el autor es una persona o ChatGpt. Vale que uno de los textos sí se obtiene ese resultado, pero en general, se ha producido un 38% de fallos. No es para tirar cohetes, desde luego…

- Tampoco se observa una diferencia en la calidad percibida de los textos. Como se puede observar, las valoraciones son muy similares en ambos casos.

- Y hay un detalle imbatible: la rapidez. Unos pocos segundos contra unos tiempos entre 25 y 45 minutos…

En el siguiente artículo trataremos de mostrar algunas herramientas para detectar textos escritos por ChatGpt y pasaremos los textos por las mismas para ver el resultado.